Le SEO des années 2010 : compilation de nos actualités

Le SEO a-t-il beaucoup évolué depuis le milieu des années 2010 ? Oui… et non : pour vous faire une idée, ou parce que les pandas, manchots et autres pigeons ne vous évoquent pas grand-chose, nous vous invitons à vous replonger avec nostalgie (ou pas!) dans les principaux articles SEO parus au cours des six premières années d’existence de VU DU WEB (2013-2018) ! (Spoïl : les fondamentaux sont toujours là !)

Les tubes de l’été 2014 de Google

(Août 2014)

Si l’une des figures de Google, Matt Cutts, s’est octroyé de très longues vacances, l’activité estivale du moteur, au contraire, a été plutôt dense. Quelques points à retenir en ce début de rentrée.

Des pandas bronzés, bercés par le roucoulement des pigeons…

Pas mal de choses ont en effet bougé ces deux derniers mois sur le moteur, entre le traitement intensif des demandes du droit à l’oubli qui ont littéralement explosé (plusieurs dizaines de millions de demandes à ce jour !), et – ce qui nous intéresse le plus- des remous notables dans les résultats des pages de recherche. Toutefois, peu de déclarations officielles ont été faites de la part du moteur : le seul aveu notable à se mettre sous la dent a été celui d’un petit coup de pouce envers les sites sécurisés (via le protocole https) lequel –au regard des tarifs- a surtout fait du bruit chez les fournisseurs de ces services, à savoir celui des bouteilles de champagne que l’on débouche !. Chez les référenceurs sérieux, ce n’est qu’un petit critère parmi tant d’autres pour l’instant qui s’ajoute à la longue liste de ceux déjà existant : nombre de freins autrement plus pénalisants sont à régler dans 99% des cas avant d’investir (parfois lourdement) dans une refonte « sécurisée » (notons aussi qu’en parallèle, le programme publicitaire Adsense de Google préconise d’éviter cette sécurisation !). En revanche, quelques secousses plus sérieuses ont agité la « SEOsphère » cet été :

– la première, le 24 juillet, a été interprétée comme les effets d’un nouvel algorithme impactant les recherches locales. Le site de référence Search Engine Land qui l’a identifié l’a affublé du nom de Pigeon : non pas parce que c’est un oiseau (comme les précédents Penguin et Hummingbird) habitué des centres urbains… ou de la place St Marc à Venise (Google Venice est le nom d’un autre algorithme « local »), mais parce qu’il a tend à retourner chez lui toujours au même endroit. Manifestement, ce déploiement n’a eu lieu qu’aux Etats-Unis et pour la seule langue anglaise, mais elle ne saurait tarder en Europe (signalons à l’occasion des petits changements d’affichage des résultats sont d’ailleurs apparus ces dernières temps pour les grandes villes et pour certaines requêtes, comme ce carrousel de photos).

– la seconde a eu lieu autour du 7 août : elle a été rapidement appréciée à l’échelle mondiale au travers des outils qui prennent la température des positions sur les moteurs, notamment sur les pages de Google (par exemple 7/10 sur l’échelle de Ranks.fr ; 85° sur Mozcast). L’agitation a perduré les jours suivant à des degrés divers. Ce changement serait le plus important de l’année (après PayDay Loan 2 en Mai, toutefois plus ciblé), mais aucun commentaire n’a été fait depuis Mountain View. Il s’agirait sans doute d’un coup de Panda –désormais intégré dans les mises à jours régulières et automatiques- un peu plus fort que d’habitude, car parmi les victimes on dénombre plutôt des sites au contenu majoritairement pauvre ou dupliqué.

– dans la foulée, à la mi-Août, des réseaux de liens européens subissaient des pénalités : Google+ de Google Webmaster annonçait 2 réseaux de liens comme cible (sans doute Rankseller et Teliad), mais plusieurs annuaires ont vu parallèlement leur Page Rank dégringoler (et même passer à 0 la plupart du temps). Les pénalités seraient manuelles, et une action similaire avait d’ailleurs ciblé des réseaux polonais quelques semaines plus tôt.

– Enfin, John Mueller, le remplaçant de Matt Cutts, annonce la fin de la prise en compte de l’authorship fin août, tandis que la surpression des photos des auteurs dans les pages de résultats, annoncée au tout début de l’été, apparaît effective à ce jour : la page de google concernant balise rel= »author » annonce la couleur concernant la pertinence de cette dernière! En revanche, les signaux sociaux de ceux qui se sont inscrits sur GoogleMyBuisness semblent demeurer effectifs. A suivre.

L’automne de tous les dangers?

2013 avait fait l’objet d’un nombre record d’améliorations de Google : le chiffre de 890 a été annoncé par Amit Singhal en personne! Et nous ne sommes pas au bout de nos surprises pour cette année, notamment dans les mois à venir, puisque, outre Pigeon en Europe, l’arrivée d’une nouvelle grosse mouture de Penguin, la troisième du nom, après bientôt un an d’exil sur les banquises de la planète numérique, va sans doute faire un gros ménage cet automne, en mal ou en bien (les levées de pénalités sont attendues) et est donc attendu plus ou moins impatiemment et avec plus ou moins d’inquiétude par tous.

Bref, rien n’est acquis, comme d’habitude, avec Google. Les optimisations fondamentales resteront sans doute des valeurs sûres, mais bien malin celui qui prétendra avoir en main toutes les solutions pour envoyer un site flirter rapidement avec les premières positions. Mais quoiqu’il en soit, plus que jamais la mise en place et le suivi d’une politique de référencement pour assurer la réactivité face aux changements sont essentiels pour assurer la visibilité d’un site et gagner ou maintenir ses positionnements dans les pages de résultat : Bref, un référencement de qualité qui nécessite une approche professionnelle englobant un examen complet et régulier d’un site, ce que nous faisons en permanence chez Vu Du Web !

L’éducation au cœur des stratégies de référencement naturel internationales

(Mai 2015)

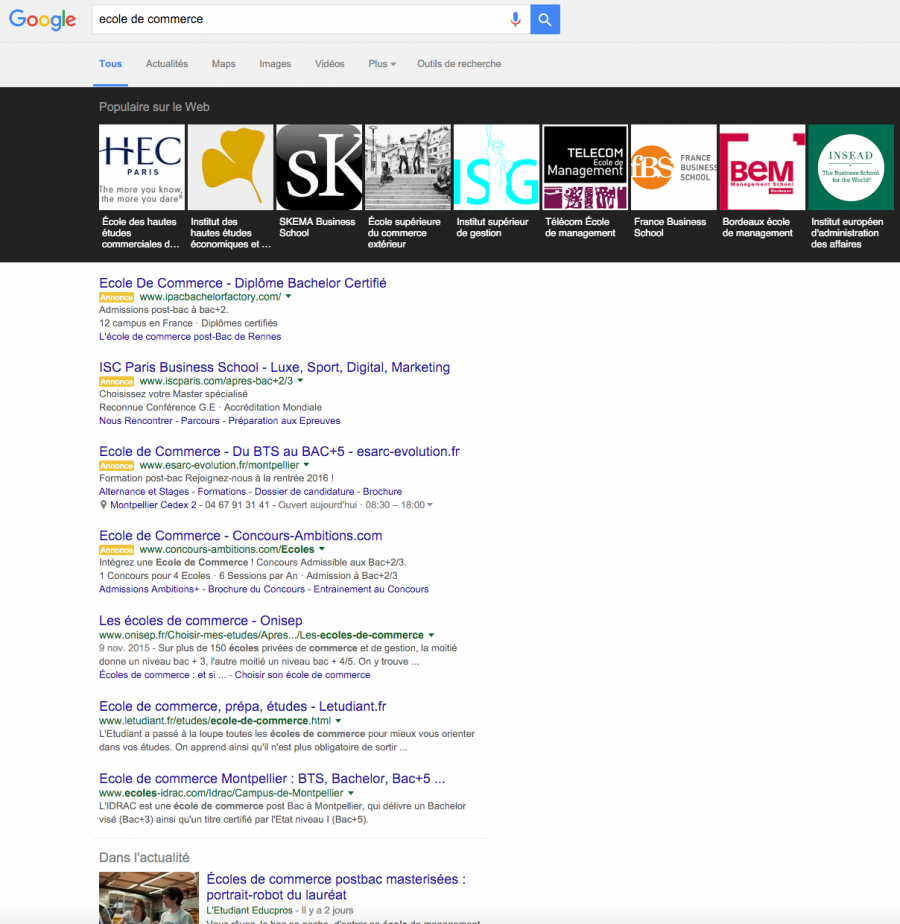

Les écoles supérieures recherchent aujourd’hui les meilleurs talents internationaux grâce à une stratégie de référencement naturel.

- Accompagner les clients dans des stratégies de référencement à échelle nationale est un fait.

- Accompagner les entreprises dans leurs projets d’expansion à l’international en est un autre.

Aujourd’hui, nombreuses sont les entreprises qui veulent dépasser leurs frontières nationales pour toucher les consommateurs étrangers. Pour mieux toucher ces consommateurs, le référencement de leur site dans les pays cibles visées est crucial. Un secteur bien particulier tel que l’enseignement est aujourd’hui à la recherche de talents à l’échelle planétaire. Ce secteur s’inscrit dans une lutte mondiale pour se positionner de la manière la plus efficace possible face à la concurrence pour attirer les étudiants venus de tous horizons.

Vu du Web fait un zoom sur un secteur en plein essor à l’échelle internationale et pour lequel le défi du référencement est à relever dès aujourd’hui…

Des étudiants de tous horizons mais avant tout Chinois !

Le secteur de l’éducation supérieure est en pleine effervescence suite à l’annonce des derniers chiffres de l’OCDE et de l’UNESCO. En effet, ce secteur s’est mis à la conquête d’étudiants étrangers depuis quelques années.

L’Amérique latine toujours séduisante…

Au Mexique, Campus France organisait sa 6e tournée entre le 25 et 29 mars 2015 à Guadalajara, Mexico et Monterrey pour faire la promotion des écoles de management et de commerce, des écoles d’ingénieurs, des écoles de design et d’art. Cette rencontre pourrait se résumer à un speed-dating entre écoles françaises et étudiants mexicains. L’année d’avant, cette manifestation avait déjà permis d’organiser plus de 1200 rendez-vous sur site, concrétisant ainsi l’arrivée de plus de 500 étudiants mexicains sur notre territoire. Ces derniers restent attirés par la reconnaissance internationale de l’enseignement français et d’une expérience francophone riche.

Les établissements supérieurs français, à la conquête du marché chinois!

Cette semaine, c’est l’Ambassade de France en Chine qui a eu l’initiative d’inviter les établissements d’enseignement supérieur français à être représentés lors du China International Exhibition Tour. Cette manifestation aura pour vocation de répondre à l’immense demande des étudiants chinois de venir étudier en France. En effet, en 2014, l’OCDE annonçait déjà qu’un étudiant sur deux serait d’origine asiatique. L’UNESCO va plus loin en affirmant que les Chinois sont en passe de devenir la première communauté d’étudiants étrangers de France. Aujourd’hui la population étudiante chinoise en France représente près de 35 000 jeunes. Ces nouveaux chiffres montrent que les établissements d’enseignement supérieur français doivent s’ouvrir à des profils internationaux.

Des étudiants séduits mais toujours à convaincre…

La France dispose de nombreux atouts pour séduire différents profils d’étudiants internationaux. Cependant, faut-il encore savoir les mettre en avant de la meilleure manière.

Comment se rendre visible sur des cibles internationales ?

Les étudiants sont aujourd’hui tous connectés et disposent de nombreux supports pour avoir accès à internet et aux réseaux sociaux. La présence d’un site internet et de réseaux est donc indispensable pour attirer l’attention d’éventuels étudiants étrangers.

La stratégie numérique devra aussi aller bien plus loin qu’une simple présence sur le net. Elle devra se faire dans leur langue et sur les supports locaux. Le référencement naturel devient donc un levier stratégique pour se rendre visible aux yeux de ces étudiants. Pour cela :

- certains passent par la traduction littérale de leur site en plusieurs langues,

- d’autres offrent une version anglaise en étant référencé dans plusieurs pays

- ou d’autres encore se font référencer directement dans les pays cibles en utilisant des sites internet complètement détachés de leur site local…

C’est le cas de certains écoles de commerce ou d’ingénieur, qui, pour attirer les étudiants chinois se référencent sur Baidu, le géant des moteurs de recherche chinois. Bref, l’intérêt qu’ont les écoles supérieures n’est plus à démontrer.

Les stratégies à mettre en œuvre pour cela passeront forcément par le référencement naturel afin de faire en sorte que les étudiants friands du modèle et de la qualité éducative à la française aient à disposition sur le net toute l’information nécessaire et utile à leur prise de décision.

Attirer les meilleurs pour faire rayonner la France

Du point de vue des écoles, cette internationalisation ne doit pas seulement se faire pour répondre à une demande croissante des étudiants étrangers. Elle doit également permettre d’offrir les meilleurs talents d’autres pays.

Etre en adéquation avec les attentes des entreprises

Nos entreprises réclament aussi les meilleurs étudiants. En plus d’attirer l’élite étrangère, les écoles françaises se doivent aujourd’hui d’offrir une vision et d’accueillir des étudiants de tous horizons pour disposer d’une représentation à petite échelle de notre monde. Cela aura pour effet de partager l’éclairage culturel de certains aspects enseignés.

Savoir se poser les bonnes questions

Il est donc crucial pour les établissements d’enseignement supérieur de se poser les bonnes questions pour se lancer à la conquête des étudiants internationaux et ainsi attirer les meilleurs talents. L’une de ces solutions sera apportée par un référencement naturel efficace sur les moteurs de recherches locaux et dans la langue cible.

Nos 10 conseils pour optimiser votre site pour le référencement naturel

(Juillet 2015)

1. Ajoutez vos mots-clés et exploitez le champ lexical autour de votre domaine

Il est important que votre contenu soit pertinent pour le référencement de votre site. Plus vous vous appliquerez sur le champ lexical de votre domaine, plus Google comprendra le contenu de votre site et cela l’aidera à mieux vous référencer. Il est bon de définir un mot clé cible par page afin que Google renvoi l’internaute sur l’information précise qu’il recherchait en premier lieu.

2. Evitez la triplette automatique : URL – Titre – h2

Il est préférable de ne pas utiliser exactement les mêmes termes dans l’Url, le Titre et le h2. En utilisant un vocabulaire plus diversifié (en changeant quelques mots), cela vous permet de placer d’autres mots-clés liés à la thématique de votre page dans les « zones chaudes ». Cela permet aussi de ne pas paraitre « sur optimisé » aux yeux des moteurs.

3. Optimisez vos balises titles

La balise title est une balise importante prise en compte par Google lorsqu’il analyse votre page en HTML. Elle informe les moteurs de recherche du sujet que traite la page mais également les internautes. Plus celle-ci sera pertinente, plus elle sera crédible et votre site sera mieux référencé. Il est préférable de ne pas dépasser les 55 caractères lors de l’écriture de vos balises Title.

4. Diversifiez le contenu en utilisant des médias : Images, photos, vidéos, gif..

Ce genre de contenu est apprécié de Google et des internautes. Les internautes passeront plus de temps sur votre site/blog et cela montrera à Google que votre site est de qualité et qu’il a le mérite d’être référencé. Ces contenus sont très attractifs, l’internaute ne s’en ira pas de votre site pour cliquer sur un autre dans la seconde qui suit on appelle ça le «pogo sticking ». Google le prend potentiellement en compte du fait que vous n’avez sûrement pas trouvé ce que vous aviez l’intention de chercher sur votre site en repartant sur un autre, ce qui vous pénalise dans votre référencement.

5. Faites des liens internes

Dans votre contenu il est important de faire des liens internes vers d’autres pages de votre site (sans en exagérer). Cela permet de faciliter la navigation au sein du site et donne du poids aux pages profondes. Il est également possible de créer des ancres telles que « Sujets connexes » ou « Articles pouvant vous intéresser » pour inciter l’internaute à consulter votre site plus longtemps. Ces ancres doivent être personnalisées pour chaque page. Elles doivent impérativement pointer sur la page qu’elle suggère.

6. Optimisez les noms de vos images ainsi que des balises ALT

Cette optimisation est très importante pour le référencement naturel, il vaut mieux renommer vos images avec une description courte et pertinente afin que Google comprenne le contenu de l’image plus facilement. Les attributs Alt de vos images sont aussi importants et vous permettront de bénéficier du trafic potentiel de Google Images.

7. Améliorez la vitesse de chargement de votre site

En améliorant le temps de chargement de votre site web, vous serez avantagé et peut-être mieux référencé par Google. En effet, c’est un critère qui lui tient à cœur alors évitez toutes les lourdeurs possibles : minimisez le poids du contenu (images, vidéos), supprimez toutes les extensions inutiles, minimisez les requêtes externes etc.

8. Ajoutez à votre page les boutons nécessaires pour le partage social

En ajoutant les icônes de partage sur les réseaux sociaux, vous incitez les internautes au partage. Plus votre page sera partagée, plus Google considérera votre contenu de qualité. Les réseaux sociaux sont également pris en compte dans les résultats de recherche Google et vous permettront d’obtenir plus de visibilité.

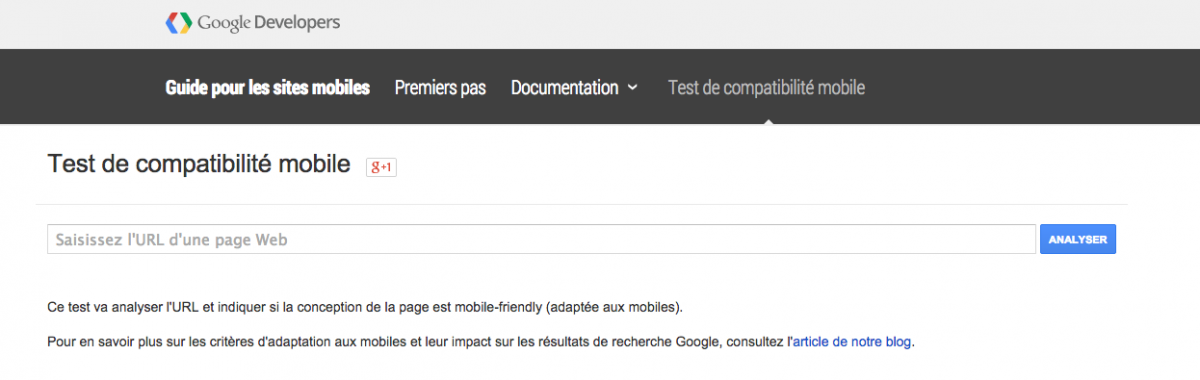

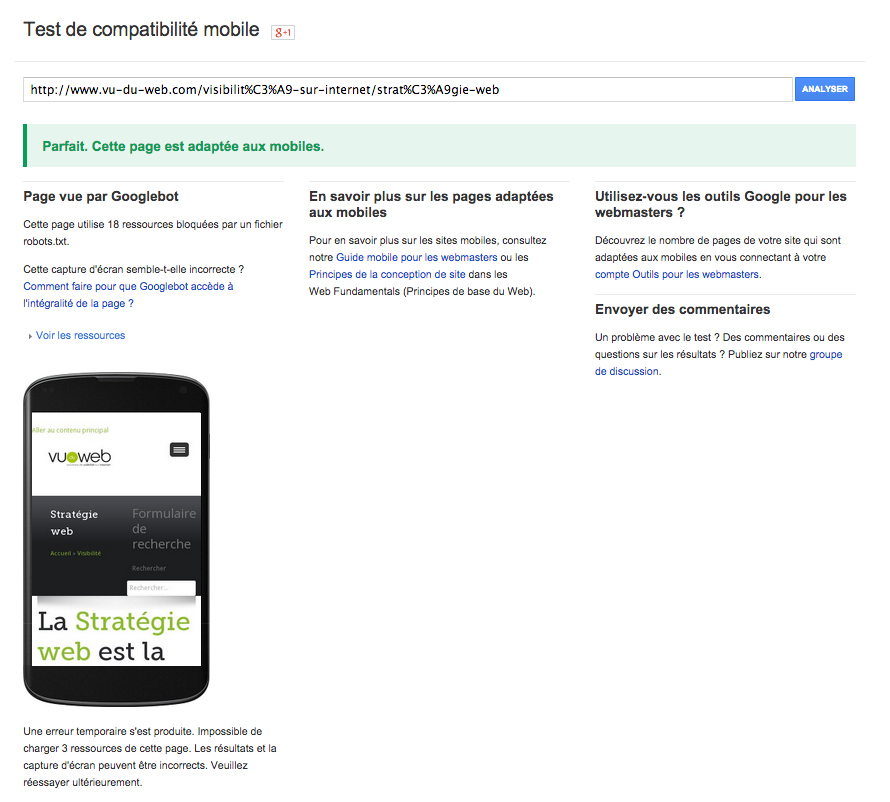

9. Soyez responsive : compatibles avec les mobiles, tablettes…

Entre site mobile séparé et site responsive, Google préfèrera le site responsive. En 2015, ce critère sera pris en compte dans le référencement. Un site responsive enverra plus de signaux positifs à Google qu’un site non responsive.

10. Ne pas avoir de contenu dupliqué en interne

Google considère que le contenu doit rendre service à l’internaute, ce qui est rarement le cas d’un contenu dupliqué. Ce type de pratique est donc trompeur et peut avoir des effets négatifs sur le référencement naturel de votre site web.

Mieux gérer son site multilingue

(Juillet 2014)

Indiquez les URL de vos pages traduites via l’attribut hreflang

Google n’a pas besoin de balises html ou de meta tags pour reconnaître la langue d’un site internet : aussi, les «» et autres « » – que l’on retrouve encore régulièrement – ne servent à rien.

D’un point de vue SEO, le problème se pose surtout quand des contenus identiques sont déclinés en copie conforme dans différentes langues, que ce soit :

- au sein d’un même nom de domaine (mon-joli-site.com/fr/, mon-joli-site.com/en/, etc.)

- via d’autres noms de domaine (mon-joli-site.com ; my-pretty-site.com).

Pendant longtemps, il n’y avait pas de solution satisfaisante pour indexer et référencer correctement les mêmes pages en plusieurs langues tout en se mettant à l’abri des pénalités liées à la duplication de contenu.

Pour pallier à ce manquement, il y a plus de 3 ans – soit (coincidence ?) un peu avant la première mouture de Google Panda– Google conseillait l’utilisation de attribut « hreflang » au meta-tag . Sur le modèle de qui indique la source d’un contenu original repris (plus ou moins) intégralement, on associe l’URL dupliquant la page courante dans une autre langue (attribut href) et l’indication sur la langue concernée voire en sus une zone géographique (attribut hreflang). Ainsi, dans notre exemple précédent, la page « mon-joli-site.com/fr/ » indiquerait :

Il est également possible d’utiliser les en-têtes http (notamment pour les fichiers hors html) et d’élaborer un sitemap spécifique (si toutes les versions sont sur le même domaine comme dans notre exemple).

Cette stratégie permet donc d’afficher les bonnes pages de destination au sein des différentes versions du moteur de recherche, mais elle n’est pas encore tout à fait entrée dans les mœurs des webmasters ou des développeurs, mais de (bons) plugins de gestion du multilingue existent au moins pour les CMS les plus courants.

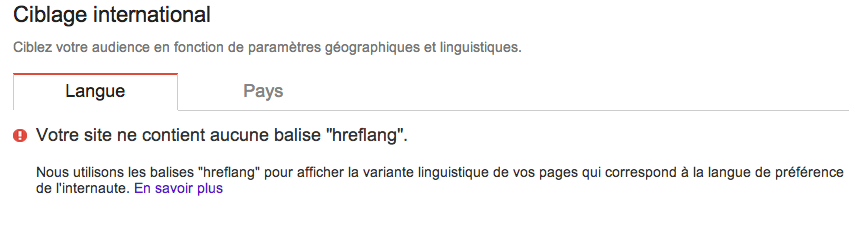

Vérifiez vos hreflangs avec Google Search Console

Le 19 juin dernier, John Mueller (de Google Zurich) mentionnait que Google travaillait sur les moyens de faciliter la gestion du hreflang via son outil pour les webmasters. Et bien c’est désormais chose faite : la mise en place, le suivi mais aussi la qualité du renseignement des attributs, notamment les erreurs (non respect de la symétrie des URL, erreur dans le code) sont désormais accessibles sur l’outil Google pour les webmasters, via le dossier « trafic de recherche », et ce jusqu’à 1000 URL.

Si le site est parfaitement paramétré, l’interface vous donnera ce type d’information :

Et si vous avez des erreurs, elles seront indiquées pour chaque ensemble linguistiquement homogène :

Pour chaque cas, des informations complémentaires (ici la liste des URL concernées par les erreurs) sont disponibles.

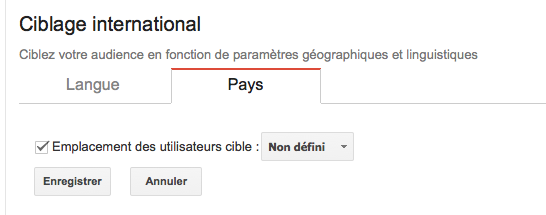

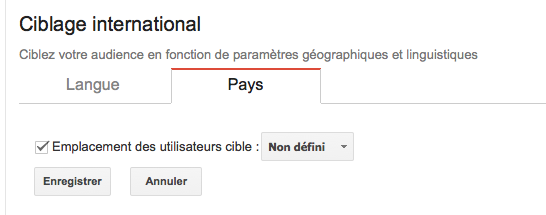

Via l’onglet « Pays », il est également possible de cibler une ou plusieurs zones géographiques spécifiques (choisir alors « non défini » dans le cas échéant comme dans l’exemple ci-dessous) :

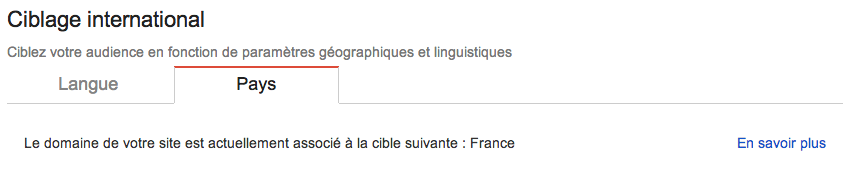

Si votre site n’est destiné qu’à un seul pays et une seule langue, vous obtiendrez plutôt ce type de d’indication si tout va bien (par exemple pour un site en français pour la France) :

Cette nouvelle interface facilite grandement le travail du SEO concernant toute la problématique du référencement multilingue.

Toutefois, les données ne concernant qu’un seul compte, ce nouvel outil n’est intéressant que dans le cas où les pages sont situées sur un même compte. Dans le cas où les URL alternatives sont situées sur d’autres domaines, et que ces domaines possèdent un compte différent, les informations seront limitées.

Référencement naturel : les optimisations on page

(Novembre 2014)

Les moteurs de recherche utilisent de très nombreux critères lorsqu’ils classent les sites web. On ne connaît pas leurs algorithmes, qui restent secrets (ce serait trop facile, sinon), mais une chose est certaine : ils sont très complexes et prennent en compte des dizaines de critères.

Les axes pour améliorer son site et faire les yeux doux à Google sont donc multiples. Aujourd’hui, Vu du Web vous propose d’apprendre comment rendre vos pages pertinentes par les critères on page.

SEO on page : le contenu est roi

Par SEO on page, on entend tout le travail d’optimisation directement sur votre page web, notamment en ce qui concerne les textes, qui sont un critère clef. Il ne faut pas oublier que Google et les autres moteurs de recherche travaillent avant tout pour l’utilisateur, qui veut des résultats de recherche qui répondent à ses besoins. Pour apporter les meilleurs résultats possibles, les moteurs doivent donc faire en sorte d’y faire apparaître des pages de qualité, sans quoi l’utilisateur pourrait finir par se tourner vers la concurrence. Et à quoi peut-on reconnaître une page de qualité ? A son contenu.

Google ne peut pas juger de la qualité de vos services ou de vos produits, ce n’est donc pas un critère de classement (mais qui sait ce que nous réserve l’avenir ?). Il pourra en revanche juger les performances techniques de votre site (temps d’accès, présence ou non d’erreurs 404, etc.) et des liens externes qui pointent vers lui. Mais aujourd’hui, nous allons nous concentrer sur ce qui, aux yeux des moteurs, constitue un contenu qui mérite d’arriver en première place.

L’URL et les bons mots-clefs

Le référencement naturel doit être pensé en amont de la création du site car il est difficile de revenir sur certains critères après la mise en ligne.

Par exemple, l’URL de vos pages doit refléter leur contenu. Il faut y insérer les mots-clefs en rapport avec le sujet. Ainsi, si votre site vend des accessoires pour moto et que vous avez une page spéciale pour vendre des casques, vous pourrez opter pour l’URL suivante : www. accessoires-moto.fr/casques. Attention cependant, les moteurs de recherche détestent quand on en fait trop. Pour eux, il s’agit d’une tentative d’abuser leur algorithme. Ainsi, une URL du type : www.accessoire-moto-pas-cher-herault-languedoc-roussillon.fr/casques-pas-chers-a-vendre-neuf-occasion sera très mal perçue. Placer autant de mots, n’est pas naturel. Qui, en voulant créer un site pratique d’utilisation, aurait l’idée de mettre en place une URL si longue et compliquée ? Restez simple et mesuré.

Par ailleurs, attention à la création automatique de pages (avec Java ou PHP, par exemple) ! Certes, ce type de technique présente de nombreux avantages, mais si toutes les URL de votre site sont créées de la sorte, vous risquez d’y retrouver énormément de chiffres ou de suites de lettres qui ne forment aucun mot. Vous perdriez la possibilité de créer des URL pertinentes. Au contraire, elles seraient très difficiles à retenir et à taper. Les moteurs de recherche s’en rendront compte et favoriseront des URL humainement faciles à retenir. Faites donc attention à la création automatique d’URL, qui peut donner des résultats fâcheux.

Les balises meta

Premièrement, la title (classée ici dans les méta mais qui n’en est pas une) n’est pas à négliger. Il s’agit du titre de votre page, celui que l’on retrouve écrit en gros dans les résultats de recherche. Les moteurs concluent que les mots qui s’y trouvent sont particulièrement pertinents pour cerner le sujet abordé. Ainsi, comme pour l’URL, placez-y les mots-clefs pertinents pour votre page sans trop en faire. N’oubliez pas également que l’utilisateur se basera sur cette « balise » pour décider ou non de cliquer (Attention, le CTR (taux de clic / affichage) du résultat naturel aurait un impact sur le positionnement). Comme toujours en matière de référencement, pensez à l’utilisateur et restez mesuré !

La meta description est d’ailleurs votre allié pour encourager l’utilisateur à venir vous visiter. Elle n’est pas prise en compte par les moteurs, alors tentez surtout d’y placer un discours pertinent par rapport à la requête pour laquelle vous optimisez votre page, qui plaira à l’utilisateur et rendra votre site attractif.

Dans les deux cas, veillez à ne pas dépasser la limite de caractères ! 60 caractères (espaces compris) pour la title et 160 (espaces compris) pour la description. En cas de dépassement, votre message ne s’affichera pas entièrement et les petits points que l’on verra alors ne donneront pas une image très professionnelle de votre entreprise.

Quant à la meta keywords, elle a été tellement surexploitée que Google ne la prend plus en compte aujourd’hui. Ne perdez donc pas de temps à la renseigner.

Les textes : le cœur de votre page

Les textes ne sont pas à négliger. N’en avoir aucun sur son site est extrêmement pénalisant, étant donné l’importance accordée par les moteurs à ce que vous dîtes. Il faut être utile et unique. Ne copiez-collez surtout pas le contenu d’un autre site, cette technique dangereuse pour votre SEO est à proscrire !

Certes, il peut être difficile de savoir quoi écrire. Réfléchissez à ce qui peut intéresser un internaute qui visite votre page et écrivez à ce sujet. Pour l’exemple donné plus haut, qu’est-ce qui peut intéresser un internaute qui veut s’acheter un casque de moto ? On peut par exemple penser qu’il cherche une marque en particulier, qu’il cherche une taille précise. Pourquoi ne pas en parler sur votre page ? Rédigez un paragraphe où vous expliquez que vous vendez de bons casques, un autre pour expliquer que vous proposez des produits de nombreuses marques (profitez-en pour placer les noms des marques phares, celles qui se vendent le mieux) et que vous proposez toutes les tailles. Avec ceci, vous aurez une chance de capter un trafic plus varié que si vous n’aviez eu aucun texte. Chaque page doit être unique et faire l’objet d’une réflexion pour cerner les mots-clefs pertinents.

Attention encore une fois à rester naturel ! Ne placez pas 50 fois votre mot-clef par paragraphe et ne placez pas le même texte dans tous vos titres ! Qui ferait ça ? Une telle pratique ferait bien trop penser à un texte écrit pour les moteurs uniquement (ce serait justifié), sauf que selon Google et ses confrères, c’est pour l’utilisateur que vous devez écrire. Une densité de mots-clefs trop élevée aura des effets néfastes sur votre positionnement.

Vous devez également soigner la structure de votre texte avec les h2, h3, etc. Là encore, placez-y quelques mots-clefs de façon mesurée. Notez qu’il est préférable de ne pas placer exactement les mêmes termes à la fois dans la meta title, l’URL et le h2. Variez vos mots-clefs, cela vous permettra de vous positionner sur plus de requêtes tout en restant naturel.

Quand vous rédigez vos textes, n’oubliez pas de placer également des liens internes. Ils permettent de répartir le « jus de référencement » d’une page à l’autre. Supposons qu’une page A soit très bien considérée par Google et qu’un de ses liens pointe vers la page B. Le moteur de recherche conclura que puisque A, qui est une page de qualité, pointe vers B, cette dernière est probablement de qualité aussi, ce qui se traduira par un meilleur positionnement. En développant un maillage interne, vous pourrez faire bénéficier à toutes vos pages (y compris les plus profondes) de vos efforts pour faire remonter certaines pages dans Google. Là encore, le naturel reste de mise. Vous devez éviter de placer trop de liens sur une même page. Non seulement cela réduit leur efficacité (plus il y a de liens, moins leur impact sur leur cible est important), mais en plus ça n’est pas du tout naturel. Arrivé ici, vous avez sans doute compris : les moteurs de recherche détestent ce qui n’est pas naturel.

Soyez donc prudent : même si vous écrivez pour être bien positionné sur Google, restez systématiquement dans une logique de service à l’utilisateur.

Les images

Enfin, si vous voulez également être présent sur les recherches d’images, il va falloir optimiser vos illustrations.

Avant toute chose, assurez-vous que le fichier que vous voulez installer sur votre serveur ait un nom pertinent. Pas de 45235.jpg ! Choisissez plutôt : casque-moto-nexx.jpg, qui aura un sens véritable et sera valorisé par les moteurs de recherche. Ensuite, prenez garde dans le code à bien renseigner les attributs title et surtout alt avec des mots-clés pertinents pour l’image.

Google utilisera également le texte présent autour de l’image pour juger de sa pertinence. Raison de plus pour créer du texte de qualité sur vos pages.

Phantom : une arrivée discrète et des résultats surprenants

(Juin 2015)

Début mai, le monde du SEO était en alerte devant de nombreuses variations de trafic. Il était question d’une importante mise à jour algorithmique.

Confirmée depuis peu par Google, il apparaît qu’une mise à jour, sur les traces de Panda a bien eu lieu. Cette dernière étant intervenue furtivement et sans annonce préalable, le nom de Phantom lui a été attribué. On a également parlé de Phantom 2 puis qu’une version préalable Phantom 1 non confirmée par Google aurait eu lieu en 2013 à la même époque.

Des suppositions, et que des suppositions

Cette mise à jour semble similaire au filtre Panda, puisqu’elle vise à juger la qualité du contenu. Elle a été qualifiée par Google de « quality update ».

Il apparaît selon les premières estimations que les pages à faible contenu seraient les plus touchées par cet algorithme. L’idée étant, comme toujours pour Google, de favoriser l’expérience utilisateur.

Les sites ayant un excès de vidéos, de pop up ou de pub se sont alors vus littéralement chuter dans les SERP.

Des suppositions à confirmer dans un avenir proche

Passer du côté obscur à cause d’un spam : un exemple

(Novembre 2014)

La menace fantôme

La première fois que j’ai lu le mot « spam », j’avoue avoir bien rigolé. Mais c’était il y a longtemps. Je vous parle même d’un temps que les moins de vingt ans ne peuvent pas connaître : Google en ce temps là venait tout juste de naître sous le regard condescendant de Lycos, Yahoo et autre Altavista, et la guerre des étoiles n’était pas encore traduit par « star wars » en français, c’est pour dire… Ainsi, un beau matin, le responsable informatique de l’honorable institut dans lequel j’évoluais nous avait alors fendus d’un courriel qui nous mettait en garde contre les spammeurs, mais dans des termes incompréhensibles pour le commun de ses destinataires, ce qui avait engendré malgré lui un effet ostensiblement comique au lieu d’être qu’inquiétant. J’avais alors envoyé du tac-o-tac, hilare, un mail à toute la communauté pour tenter de leur expliquer le mot « spam » en inventant une origine farfelue (je ne me souvenais pas du fameux sketch de Monty Python), soit une contraction du verbe « se pammer », état émotionnel dans lequel s’étaient trouvés les hackers après avoir piraté les statistiques de fréquentation des internautes de mon université : car déjà à l’époque, les sites « adultes » tenaient le haut du pavé chez mes collègues…Aujourd’hui, après avoir basculé comme référenceur, le mot spam m’apparaît nettement moins amusant, surtout quand il s’agit de définir ce qui est de nature à appâter l’un des animaux du bestiaire de chez Google vers l’un des sites que je suis censé au moins maintenir dans les hauts des pages de résultats de ce même Google. Jusqu’alors, je n’avais pas vraiment eu à faire face à de graves menaces, or, Il y a quelques jours, je me suis trouvé face à l’un de ces hacks sur wordpress qui a défrayé la chronique cet été.

La traque des clones

La victime, un site d’information dont le trafic avait sensiblement chuté quelques jours auparavant, générait sur chacune de ses pages –soit plus d’un millier – un lien vers des dizaines d’autres sites wordpress de toutes nationalités, avec des pages de destination quasi-clonées au travers d’une trame rédactionnelle identique et bourrée de mots-clé vantant les vertus d’un médicament stimulant la viilité masculine (la seule variable). Toutes ces pages offraient un accès indirect (via un lien masqué qui ne se chargait et s’activait qu’après le clic sur l’image principale) vers un site canadien de vente en ligne dudit médicament providentiel. Le backlink en question était posé de manière à être invisible à l’écran par un positionnement largement hors cadre (-3000 à -5000 px en haut à gauche) et changeait à chaque chargement.

De leur côté, les sites pointés (je passe au présent car c’est toujours le cas pour les ¾ des nom de domaines identifiés) hébergent malgré eux toute une arborescence de pages « spammy » sub-dupliquées (exemples ci-dessous), lesquelles se comptent parfois en centaines : des médicaments donc, mais aussi des pages faisant la promotion des fameux crédits « payday loan ». De plus, dans le contenu-même de ces pages, plusieurs backlinks pointent vers d’autres sites-victimes de manière à former un gigantesque réseau fantôme destiné à booster l’accès d’un site tiers au détriment de milliers d’autres.

Devenus complices involontaires en tant que sources de milliers de liens douteux et/ou de pages clonées tout aussi déplacées, tout ces sites possèdent donc toutes les qualités pour passer du côté obscur du web et subir les foudres filtrantes Google Penguin (réseau de liens), Panda (grosse proportion de pages dupliquées et hors sujet), et bien sûr paydayloan (filtre sur les requêtes spammy) ; c’est d’ailleurs probablement ce qui est arrivé dans notre cas d’étude qui est passé de la 1ère à la 5ème page de google sur une requête large correspondant à son coeur de métier, d’abord quelques jours avant la nouvelle mouture de Penguin, le 14 octobre (premier filtrage paydayloan ?) pour dégringoler complètement après le déploiement de ce dernier.

La revanche des sites

Le succès de Wordpres ces dernières années a permis le développement de très nombreux « plugins » qui assurent la mise en place d’une quantité de fonctionnalités sur un site web. Et ces milliers de plugins, même quand ils sont conçus par des développeurs chevronnés, ne sont pas à l’abri d’une faille que les hackers peu scrupuleux sont prêts à exploiter. S’assurer de la fiabilité d’un plugin avant de l’utiliser et assurer ses mises à jour est un minimum, mais, on l’a vu, ce n’est pas toujours suffisant pour contrer et surtout détecter que son site a fait l’objet d’une attaque.

Fin Juillet, plusieurs plugins avaient ainsi été signalés comme ayant permis l’ouverture de «portes dérobées» permettant l’accès à toute l’arborescence d’un site afin d’y déposer des fichiers malicieux. L’un deux, wysija newsletters (mailpoët), avait été utilisé, mais la mise à jour n’avait manifestement pas suffit, ni le retrait pur et simple du plugin quand le spam a été découvert. Un script php retrouvé par les développeurs était bien ancré dans le cœur même de wordpress, dans la partie destinée au templates (/generale-template.php) : ses fonctions permettaient de piocher et d’insérer dynamiquement l’une des 1500 urls contenues dans un autre fichier pirate, licence.txt. Parmi ces urls, les 3/4 répondaient toujours présentes (réponse http 200) ce qui nous autorise à penser que des centaines de sites, sinon des milliers, sont encore touchés.

Bref, que vous soyez victimes ou non, il est fortement conseillé d’effectuer un minimum de contrôles, et ceci de façon régulière :

1) Crawler son site (par exemple via des outils gratuits tels Xenu sur PC ou Integrity sur Mac) : en plus de détecter certains problèmes récurrents avec l’utilisation des CMS (multiplication involontaire de pages dupliquées ou sans contenu), un crawl mettra aussi en lumière l’ensemble des urls accessibles depuis l’arborescence théorique et l’ensemble liens sortants rencontrés. Dans notre cas, c’est ce qui a permis de détecter la présence des liens obscurs.

2) contrôler l’index de Google : un crawl ne suffit si pas les pages spammy n’ont pas de liens direct depuis les pages « théoriques » mais sont seulement accessibles depuis le réseau « fantôme » : leur présence dans l’index de Google est alors détectable via la commande « site :www.monsite.fr », ou plus précisément en détectant la présence de mots clé douteux dans l’url (« site: www.monsite.fr inurl: »viagra »») ou dans la balise title (site: www.monsite.fr intitle: »loan »). Si le résultat est positif, repérez le / les dossier(s) incriminés pour mesurer l’ampleur des dégâts (site:www.monsite.fr inurl : « /products/ ») et accélérer l’élimination des urls (voir plus bas).

3) Contrôler ses backlinks : On peut raisonnablement penser qu’un certains nombre de liens vers les pages pirates de votre site vont être détectés via les outils d’analyses de backlinks sur le marché, tel Majestic ou Ahref (y compris par les versions basiques gratuites). L’outil pour les webmaster de Google peut également vous aider à détecter un certain nombre d’entre eux. De plus, une montée brusque, tout du moins inattendue, du nombre de backlinks doit également vous mettre la puce à l’oreille quant à une possible invasion de votre site. Doublement du nombre de backlinks en quelques semaines au cours de l’été sur le même site à cause d’un spam identique sur des centaines d’autres sites

4) L’analyse des logs de votre site, notamment les visites des bots, est également riche en enseignement. Une explosion du nombre de pages visitées par rapport à ce qui est attendu (par rapport à votre sitemap théorique par exemple) doit permettre de soulever quelques lièvres, notamment dans le cas particulier où de très nombreuses pages web indésirables sont créées et surtout visitées. Pas mal de solutions plus ou moins complexes et/ou onéreuses existent sur le marché (watussi, crawltracks, botify, aposition, oncrawl…). A défaut, l’outil de Google pour les webmasters (Eploration / statistiques sur l’exploration) pourra vous donner quelques indices si un pic anormal se dessine sur le graphe, mais les données sont toutefois très imprécises.

Si malheureusement votre site est bel et bien piraté et que les mises à jour effectuées ne changent rien à l’affaire, tentez de retrouver les scripts et autres fichiers malfaisants dans l’arborescence et supprimez-les (par défaut, votre serveur renverra alors une réponse http 404 aux différentes requêtes), sinon empêchez au moins la création d’url contenant les dossiers incriminés via une fonction htaccess. Afin d’éliminer rapidement les urls indésirables de l’index des moteurs de recherche, forcez une réponse 410 si ces dernières présentent toutes un schéma récurrent (contenu dans un même dossier : par exemple, via le htaccess : RewriteRule ^(.*)/nom-du-dossier-vérolé – [G]).

Inutile de demander le désaveux des sites pointant involontairement vers vous, car cela risquerait plus de pénaliser ces derniers que de vous en faire profiter. En revanche, contrairement à ce que j’ai pu rencontrer dans mon analyse, ne faites surtout pas de redirection définitive (301) vers une page valide de votre site, car vous risqueriez de récupérer une éventuelle pénalité !!!

Mieux vaut prévenir que guérir, certes, et de nombreuses solutions sont offertes sur le marché, mais le propre du hacking est justement de détourner toutes les barrières existantes, lesquelles sont donc par définition instables et condamnées à être franchies. Bref, à moins d’être un maître jedi de la sécurité ou du développement, l’utilisation de base des CMS tels que WordPress ne permet pas de dormir sur ses deux oreilles. En revanche, surveiller un minimum l’état de son site est à la portée de tous. Mais en cas de doutes ou de gros soucis, vous aider, nous pouvons !

Google change l’indexation des applications mobiles

(Novembre 2013)

Vous n’êtes pas satisfait lors de vos recherches mobiles ? Vous arrivez sur des listes de sites qui ne correspondent pas à ce que vous voulez ? Google est d’accord et c’est pourquoi il va indexer le contenu des applications mobiles comme pour les sites web !

Qu’est ce qui change ?

Google vient d’annoncer qu’il testait actuellement l’indexation des applications mobiles présentes dans Google Play. Pour l’instant c’est donc en majorité une sélection d’applications Android qui seront soumises à l’étude de GoogleBot.

Pourquoi indexer les applications mobiles?

C’est simple, Google souhaite offrir les mêmes résultats de recherche via une application mobile que via un site web (mobile ou non). Cette annonce correspond en effet à la dynamique lancée par le nouvel algorithme Hummingbird, prenant en compte l’interface mobile.

Résultat concret pour l’utilisateur

Lorsque l’utilisateur lancera une recherche depuis le mobile, il pourra alors être redirigé directement vers un contenu pertinent dans les applications Android, plutôt qu’être renvoyé vers des pages web difficiles à charger. Le marché du mobile et l’utilisation des moteurs de recherche directement via les applications sont en telle expansion que la nouvelle indexation proposée par Google semblait inévitable.

Google réorganise sa première page de résultats

(Février 2016)

Les annonces s’enchaînent au sujet des mises à jour et des évolutions de Google. La dernière en date est en train de faire son effet dans le monde du Search : comme si le métier du référencement n’était pas assez complexe, voilà maintenant que les cartes sont une nouvelle fois redistribuées.

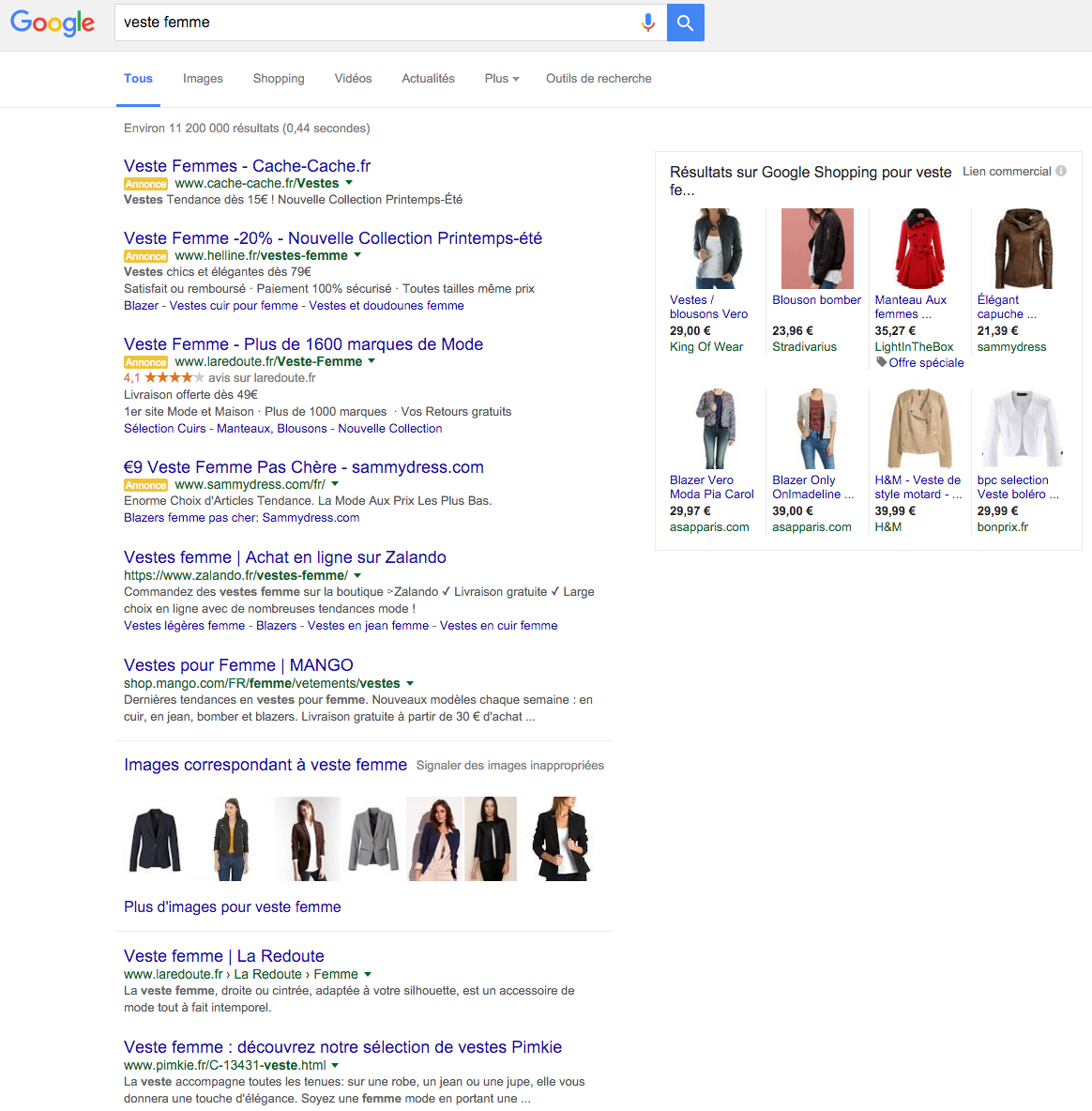

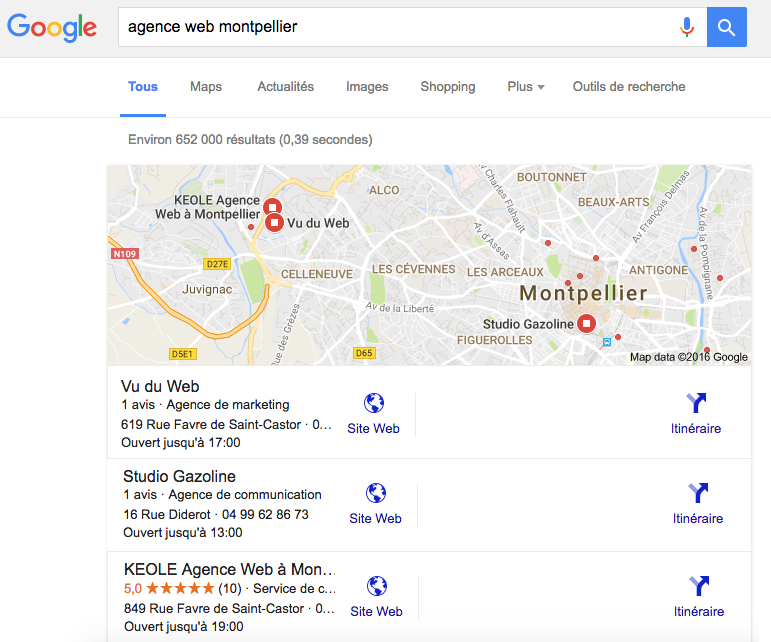

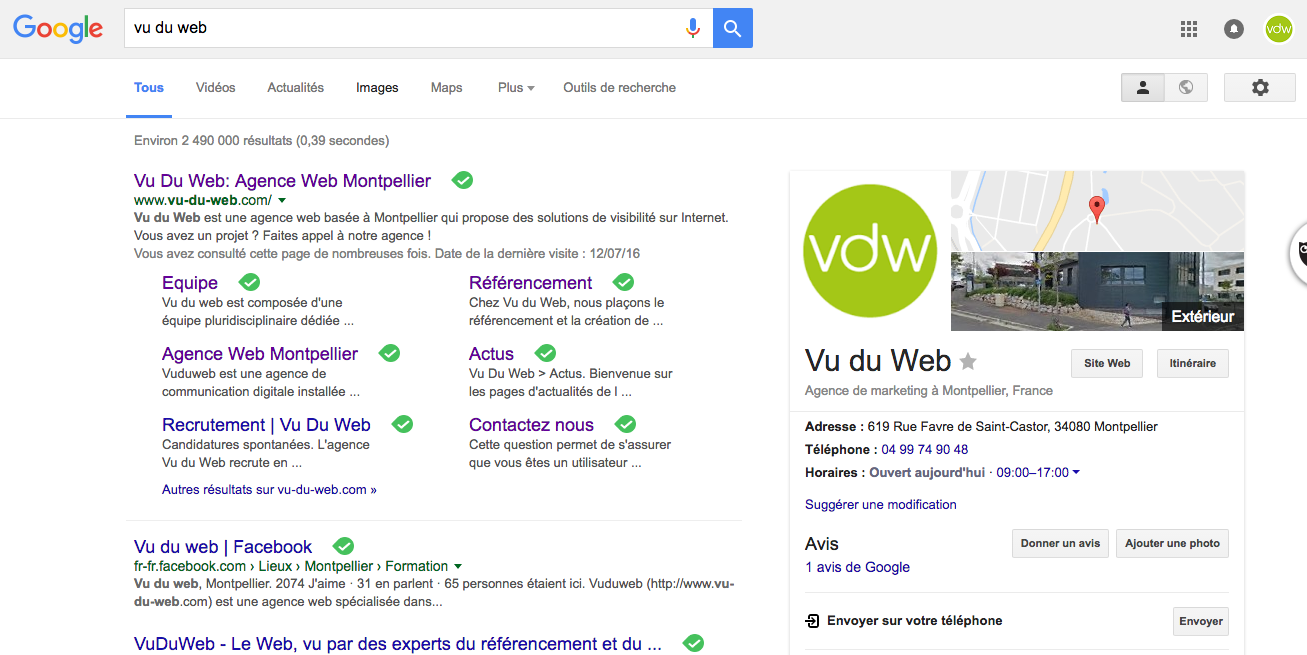

Réduction de 36% des espaces Adwords sur la première page de Google

Au-delà des 3 premiers liens payants qui se trouvaient juste en dessous de la barre de recherche suite à l’affichage des résultats, la bataille au CPC (coût par clic), se jouait pour beaucoup d’annonceurs au budget plus limité sur la colonne de droite. C’est maintenant du passé. Désormais, sur les plus gros mots-clés, ceux les plus recherchés, ceux qui représentent le plus gros potentiel de visites et de conversions, il n’y a plus d’annonces. La suppression de ces 7/8 occasions payantes de jouer dans la cours des leaders est maintenant du passé. Place à 4 positions en haut de page, à la place de 3 et à l’ajout de fonctions Google (Shopping, Google My Business : plan, avis, coordonnées, recherches associées, etc.) en colonne de droite ou même au-dessus des résultats payants (voir sur l’aperçu ci-dessous). Et l’espace publicitaire est complété en bas de page avec 3 annonces de plus. C’est 36% de possibilités en moins pour profiter d’un espace publicitaire sur la première page de Google.

L’impact évident va être une augmentation significative du coût par clic sur les requêtes à forte compétition et mécaniquement une augmentation du coût d’acquisition via ce levier.

Comment s’adapter en référencement naturel face à ce changement majeur ?

Comme souvent face aux évolutions de Google, il faut garder son calme et accepter avec beaucoup d’humilité ce changement majeur. En effet, côté référencement naturel, sur les grosses requêtes, l’impact est à première vue énorme. L’espace de la page de résultats est redistribué en laissant une place de choix aux 4 premiers résultats payants ainsi qu’aux diverses données du Graph : images, logos ou de shopping (voir ci dessous sur la requête « veste femme »).

Quelques conseils pour s’adapter en SEO ?

- Comment souvent annoncé : viser et « miser » sur la longue traîne qui devrait laisser plus d’espace et offrir de meilleures conversions en trafic naturel.

- Optimiser et ré-optimiser ses images avec l’objectif d’apparaître dans le « carrousel » de plus en plus présent, surtout sur mobile et tablette

- Travailler la compréhension du Knowledge Graph et la notion de moteur de réponses et essayer d’adapter sa stratégie SEO en ce sens, en partant du principe que demain, la recherche sera aussi et surtout vocale. L’idée ici est de savoir comment s’adapter et anticiper lors de la mise en place d’actions. Offrons donc dans nos contenus des réponses à de potentielles questions.

- Soigner le taux de clic de vos bonnes positions en première page. En effet, il est probable que la notion de pertinence des résultats et donc de taux de clic naturel soit un élément de choix dans le classement des sites. Il convient ici d’adapter avec le plus grand soin son title et sa méta description, oui oui sa méta description qui devient importante (comme avant) pour le SEO mais pas pour les mêmes raisons. En synthèse : donnez envie de cliquer et soignez votre promesse sur les pages de destination.

- Une stratégie de netlinking de qualité s’impose encore et toujours plus. En effet, contexte, puissance des liens et qualité globale sont les garants de l’évolution des positions sur la première page. Et là encore, la concurrence est rude et l’espace restreint. Il va falloir se serrer les coudes et redoubler d’imagination (ou de compétences en négociation) pour obtenir de beaux liens.

- Concernant les artifices comme le https : c’est à suivre dans le temps pour voir s’il s’agit véritablement d’un avantage (payant) pour être un tout petit peu mieux positionné.

- Le mobile friendly : c’est maintenant ou jamais, mais j’imagine que si vous avez un site positionné en 1re page c’est qu’il est adapté aux mobiles et tablettes.

- Variez les formats et sortez vos caméras, drones, gopro, micros ou autres appareils photo pour indexer des contenus différents et pouvant correspondre à un besoin de diversité de Google.

- Si votre objectif est le local, restez dans une stratégie hyper-locale et ne perdez pas de temps à chercher des positions en dehors de la géolocalisation, ça sera quasi mission impossible aujourd’hui.

Évidemment, cette liste n’est pas exhaustive, elle est pour certains évidente, mais pour beaucoup, elle propose les premières pistes d’adaptation à ce changement majeur, qui va déplacer à terme, la bataille du SEO en deuxième page de résultats, là où seulement 4 à 5% des visiteurs s’aventurent.

Bilan de l’hiver chez Google : une météo mouvementée !

(Mars 2018)

Ce début de printemps nous donne l’occasion de revenir sur les nouveautés les plus marquantes qui ont marqué l’hiver 2018 chez Google. Et comme la météo, le moteur a soufflé le chaud et le froid dans son moteur et dans ses outils. Voici les événements (non exhaustifs) qui nous ont marqués.

De gros mouvements dans les résultats

Officiellement, Google n’a annoncé qu’une grosse mise à jour le 9 mars, mais entre la mi-janvier jusqu’au printemps, les indices de turbulences ont été extraordinairement capricieux ! L’indice du Serpomètre de Ranks.fr a, par exemple, affiché pas moins de dix valeurs à 8 (et vingt à 7 !) sur une échelle de 10 pour cette seule période : l’année dernière, seul le déploiement de « Google Fred » s’était matérialisé par une valeur de 8… D’autres indicateurs confirment ces nombreuses variations hivernales. Et il est encore difficile de faire un bilan sur les gagnants et les perdants dans ces conditions de mouvement quasi-perpétuel.

Le déploiement d’une version bis et allégée de la Google Search Console

Sans doute la nouveauté la plus marquante pour les utilisateurs des outils de Google. D’abord timide, le déploiement d’une Search Console bis s’est finalisé début février. Cette nouvelle GSC n’offre encore qu’une poignée de fonctionnalités déjà présentes dans la version canonique, mais avec des évolutions notables : un rapport de performances qui permet de remonter les données jusqu’à 16 mois en arrière (contre 3 mois auparavant), la liste des pages AMP indexées (et les erreurs associées), et surtout, le détail de ce qui compose l’index de Google.

Cette dernière fonctionnalité est sans doute la plus intéressante pour l’analyse des sites, car l’examen détaillé des URL indexées par Google révèle la plupart des failles techniques où Google s’engouffre allègrement, provoquant la plupart du temps une surindexation du site par rapport au nombre de pages que l’on souhaite réellement montrer aux robots d’indexation. La console classe ainsi les URL indexées ou rejetées selon plusieurs critères. Malheureusement, la vue et l’exportation directe des résultats sont limitées à 1000, mais on espère que l’API s’adaptera bientôt avec un export plus large et plus de souplesse. En revanche, on peut partager le rapport et/ou une problématique précise à un tiers, temporairement ou non.

L’officialisation du critère de la vitesse de chargement d’un site

Un site trop lent aura de grandes chances de se voir déclassé. Fin février, Google a surtout mis l’accent sur les pages de destination des annonces Adwords, notamment sur mobile, en préconisant des temps de chargement inférieurs à 3 secondes et un temps de chargement du premier octet (le TTFB des outils comme Webpagetest) inférieur à 1,2 seconde (ce qui est déjà important !).

Dans la foulée, en plus de Google Speed Insight, des outils ont été mis en ligne pour les versions mobiles au sein d’une même page: un rapport de vitesse (basé toutefois sur une base de données limitée), un simulateur d’impact du temps de chargement en terme de revenus (pour les sites marchands notamment).

Il faudra donc insister (encore plus) sur le sujet auprès des développeurs de sites web sur ces optimisations qui touchent aussi bien le référencement que l’utilisateur, ce qui n’est parfois pas une mince affaire quand la technique utilisée manque de souplesse et que les préconisations impliquent de lourdes modifications. Les concepteurs de plugin adaptés pour CMS se frottent sans doute les mains.

Des vidéos en test au sein des positions zéro

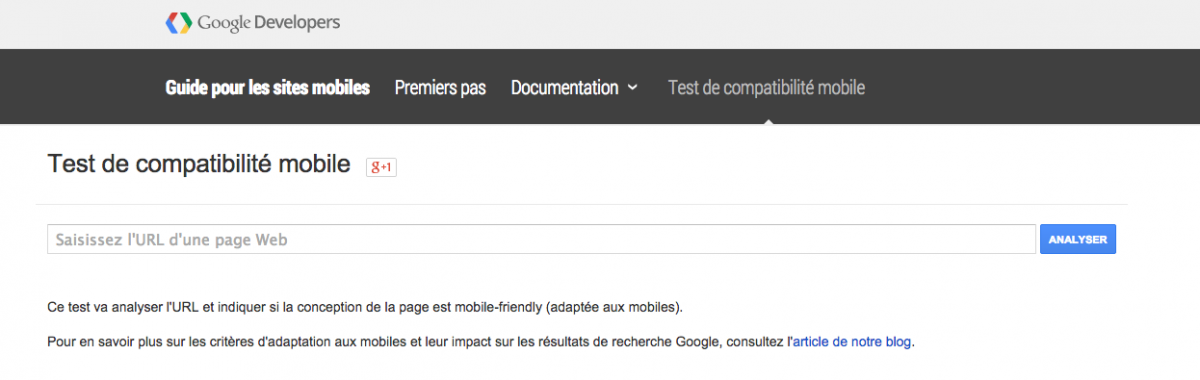

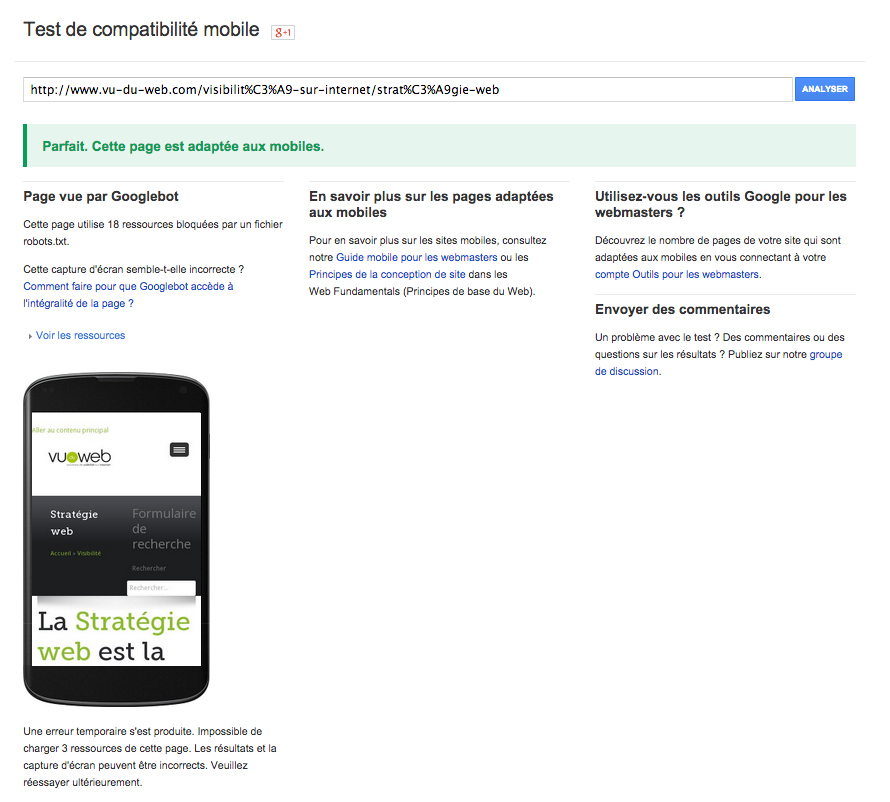

Par le biais de cet outil, vous pourrez constater si votre site est responsive selon les critères de Google.

Si votre site ne passe pas le test, le programme de Google vous fera apparaître les différentes erreurs à corriger.

La nette augmentation de la place réservée à la description dans les résultats de recherche

Jusqu’à récemment, on pouvait caser environ 160 caractères dans la « meta-description » dans les pages de résultats de Google, lesquelles offraient généreusement environ 1000 pixels. L’espace accordé a bondi de 75% (environ 1750 pixels sur ordinateur de bureau, 750 sur mobile), et il est désormais courant de voir plus de 3 lignes de texte, soit plus de 300 caractères, affichées sous les URL des pages de résultats. Il convient donc désormais de les exploiter au mieux pour inciter l’internaute à cliquer sur le lien par un message suffisamment attractif et surtout cohérent avec le contenu de la page de destination (afin d’éviter un pogo sticking nuisible : cf point suivant).

De nouvelles suggestions après un retour dans la page de résultats

Pour ceux qui doutaient encore de la prise en compte du « pogo-sticking » par Google, celui-ci se matérialise depuis la mi-février par la présence de nouvelles propositions de requêtes quand on revient sur la page de résultats après avoir visité l’unique page d’un site durant quelques secondes : un bloc de « recherches associées » s’affiche alors directement à l’endroit où l’on avait précédemment cliqué. Cette fonctionnalité va sans doute permettre au moteur de recherche de modifier le classement des résultats, de manière brute ou par rapport aux intentions de recherche.

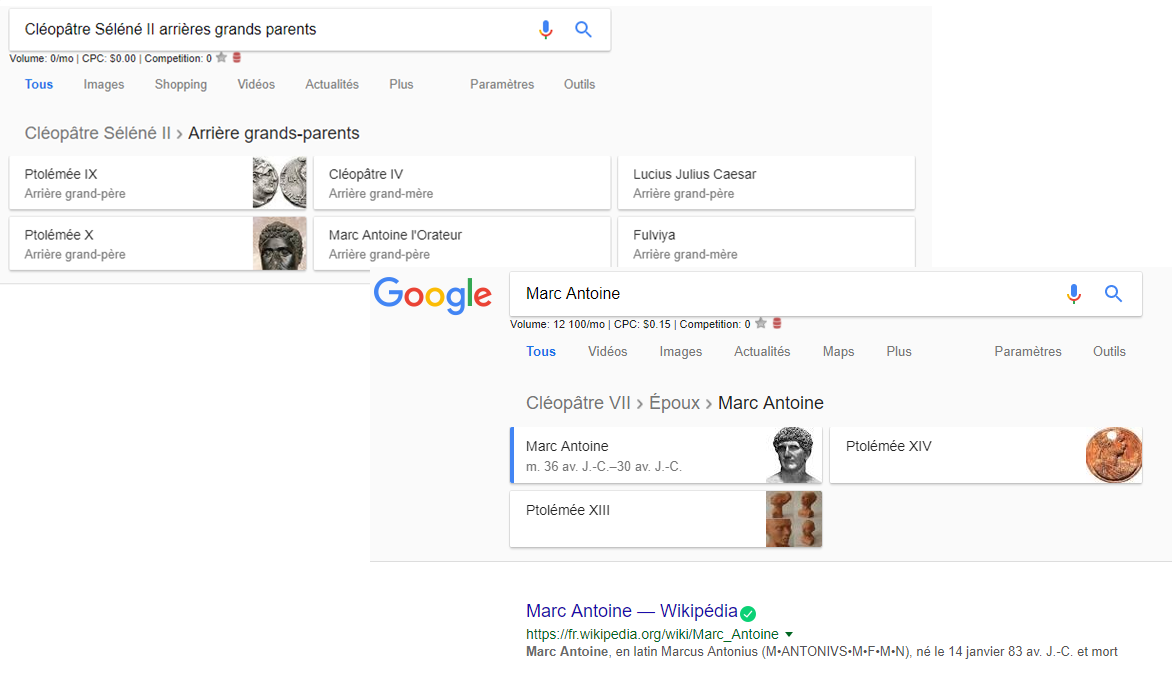

Des fils d’Ariane en top position

Certaines requêtes provoquent la création d’un fil d’Ariane sous forme classique et par des onglets illustrés . C’est notamment le cas pour les relations entre les personnalités présentes dans le graphe de la connaissance, les fonctions des principaux hommes politiques.

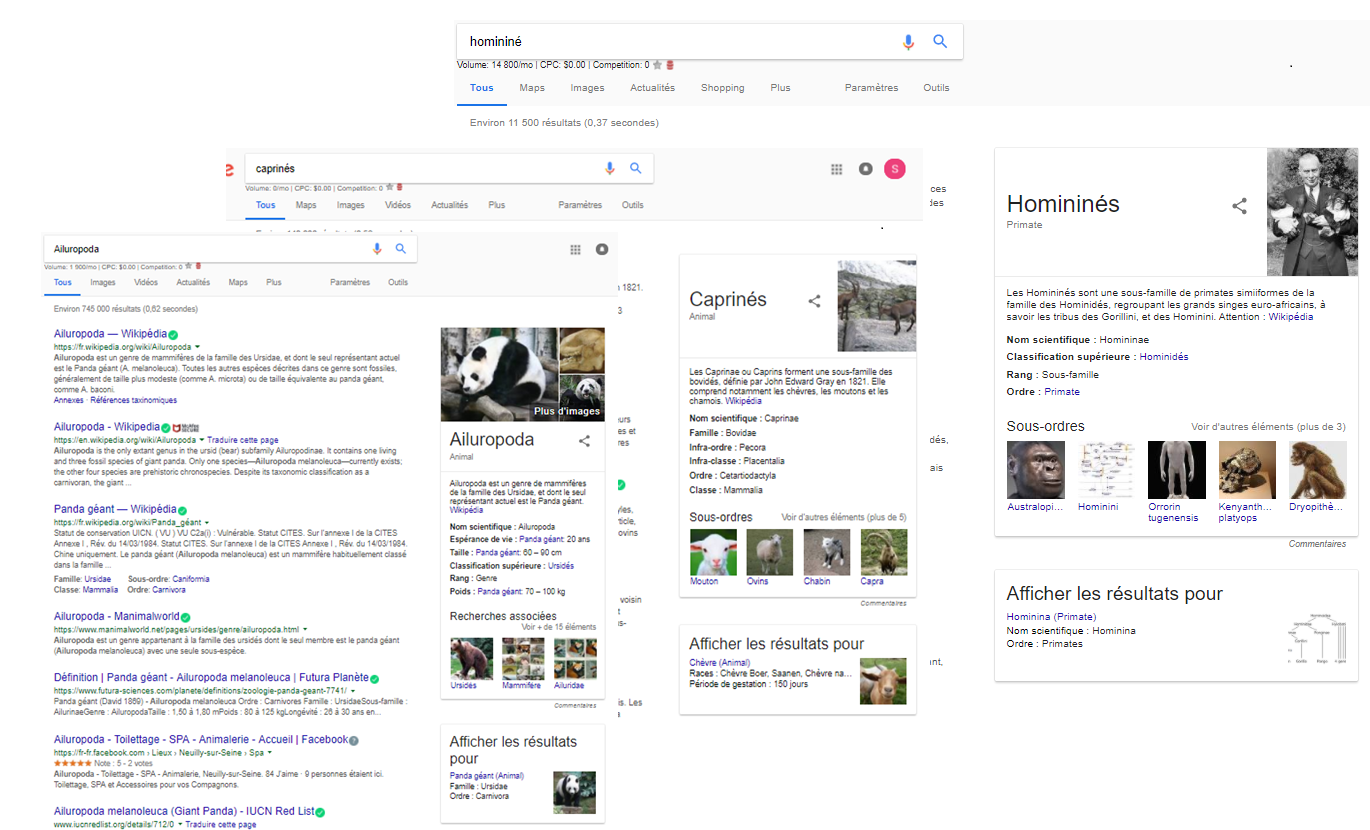

Des propositions de recherche spécifiques :

À relier aux évolutions précédentes : une recherche sur un clade de mammifère (et parfois même sur un nom vernaculaire) peut entraîner l’apparition d’une seconde « boîte » sous celle du graphe de la connaissance dans laquelle Google propose quelques informations et un accès vers les résultats d’une espèce commune au clade recherché, voire vers un autre clade. Sur ces derniers résultats, un fil d’Ariane apparaît tout en haut de la page (comme dans le point précédent).

Un passage au https quasi obligatoire pour l’été

Après les alertes sur les formulaires des sites non sécurisés, Google a annoncé que son navigateur Chrome affichera directement une alerte dans la barre d’adresse de sa 68ème version dont le déploiement est prévu pour juillet 2018. Google Chrome demeurant le navigateur le plus utilisé en France (+50%) le protocole https devient un passage obligé sous peine de dissuader la plupart des internautes de visiter un site.

Google Image : des liens, des suggestions et des titres

Plusieurs nouveautés également dans la recherche d’images de Google :

- Depuis les résultats de recherche, il n’est plus possible d’ouvrir une image dans un nouvel onglet sans passer par le site qui héberge cette dernière

- Sur mobile, le titre de l’image complète les informations (d’où l’intérêt de soigner les attributs des balises

)

- Des suggestions de thématiques associées peuvent apparaître sous la forme d’onglets en haut des résultats.

Des pages de résultats sans résultats naturels

Le meilleur pour la fin : pendant quelques jours, certaines requêtes n’offrent désormais plus de résultats naturels directs, telles les questions relatives aux heures (« heure + ville » uniquement), aux calculs mathématiques : une boîte donne directement la réponse et il faut cliquer sur un onglet pour avoir plus de résultats. Face aux critiques, l’expérience a pris fin à l’arrivée du printemps.

Le Référencement mobile pour rendre visible votre entreprise sur mobile et tablette

(Mars 2014)

Le SEO sur mobile constitue aujourd’hui une source d’acquisition de trafic majeure et devrait même s’accentuer encore considérablement dans les années futures. Les internautes sont de plus en plus nombreux à effectuer des recherches à partir de leurs smartphones. Vu du web vous explique pourquoi est-il temps de s’intéresser au référencement mobile afin de ne pas passer à côté d’un grand potentiel de visibilité !

Quelques chiffres et statistiques

En France, les smartphones représentent 44 % du parc des téléphones mobiles, soit 24 millions d’utilisateurs. La part de la navigation mobile représente 20% du trafic web. Les applications mobiles sont donc très importantes pour être accessibles en un clic depuis les téléphones et tablettes. Encore faut il que celles-ci soient elles même visibles dans les stores (Apple ou Google Play par exemple).

Statistique intéressante : un mobinaute utilise environ 4 applications par jour et se connecte en moyenne sur 4 sites mobiles par jours.

Le référencement mobile pour quoi faire ?

Le référencement mobile consiste à positionner un site mobile dans les moteurs de recherche ou à améliorer le classement des applications mobiles au sein des principaux stores. En effet le référencement mobile est aujourd’hui une véritable nécessité quand on sait qu’en France, un possesseur de mobile sur deux dispose d’un abonnement permettant l’accès à internet. Il est donc évident que la tendance du tout mobile est bien lancée et que les marques et les entreprises ont de grands intérêts à s’y adapter pour espérer être visible sur le web mobile dans des conditions optimales.

Les contraintes spécifiques du référencement mobile

Faire les optimisations SEO de votre site mobile, c’est décider sur quelle requêtes principales il va s’afficher. Pour les applications mobiles déposées sur un Store, il sera nécessaire d’effectuer des optimisations sur les titres, les descriptions, les auteurs, surveiller les avis, les étoiles, les notations ou les commentaires.

Procéder à l’optimisation SEO d’un site pour les usagers de smartphones, c’est aussi s’adapter aux contraintes techniques de la navigation mobile. Si les critères classiques du SEO sont à prendre en compte (optimisation technique, optimisation éditoriale, netlinking …), d’autres facteurs interviennent pour le référencement d’un site mobile.

Il s’agit notamment de la nécessité de proposer un site web au design 100% web responsive, c’est-à-dire qui s’adapte au format spécifique des téléphones portables. Le format doit être compatible avec les navigateurs des téléphones à l’instar du langage XHTML mobile. La création d’un sitemap mobile est également un facteur indispensable pour pouvoir être lu par les bots mobiles. Le temps de chargement constitue aussi une clé du succès en matière d’optimisation SEO sur smartphone.

Pimp My Google My Business pour le référencement local

(Juillet 2016)

Oui, on a osé faire l’analogie avec Pimp My Ride. Quoi ? Vous ne connaissez pas l’émission Pimp My Ride ? Laissez-nous vous éclairer. Cette émission de TV fut célèbre dans les années 2000 pour son concept assez décalé : des spécialistes du tuning rénovent votre vieille voiture en la rendant plus esthétique et bling bling (ok, il faut aimer). Mais vous allez nous dire : quel rapport avec mon site, son référencement et sa notoriété ? C’est simple. Imaginons que vous souhaitiez “rénover” votre site pour le positionner sur la première page de Google et lui faire gagner en notoriété. Il vous faut l’optimiser, et donc le “pimper”, pour atteindre votre objectif.

Google my quoi ?

Google My Business est une page reprenant différentes informations sur votre entreprise qui sera poussée directement à un internaute sur Google maps ou Google+. Cette page sera également visible sur le moteur de recherche, lorsqu’un internaute cherchera le nom de votre marque.

Si diverses méthodes vous permettent de référencer un site sur Google, Google My Business est un bon outil pour y arriver, notamment sur des requêtes locales. Chez Vu du Web, nous vous donnons les principaux éléments à optimiser sur votre page Google My Business, pour pimper votre référencement local< :

1 : des liens externes pour la transmission

Les liens externes, ou backlinks, permettent de transmettre du “jus” sur votre site. Il vous faut donc amorcer une stratégie de netlinking pour positionner votre page Google My Business.

2 : du contenu pour le châssis

Un bon contenu sur une page Google My Business, c’est des mots-clés et des synonymes pertinents. C’est donc la structure de votre page ! Si vous optimisez cette description, Google pourra vous positionner devant vos concurrents sur des requêtes locales.

3 : de la cohérence dans les informations pour la carrosserie

Du contenu, oui, mais de la pertinence avant tout ! Pour cela, il vous faut renseigner la même adresse et le même numéro de téléphone partout sur le web. Les avis et les photos de votre page peuvent jouer également sur son positionnement. Enfin, pensez à valider votre établissement, si ça n’est pas déjà fait. Il s’agit donc d’optimiser la carrosserie de votre page Google My Business.

4 : la gestion des avis pour l’Argus

Les internautes peuvent laisser des avis sur votre page locale Google My Business, aussi soyez attentif et répondez aux avis. C’est de la réputation en ligne de votre établissement dont il s’agit.

N’oubliez pas : si votre site est votre première vitrine, votre page Google My Business est la deuxième. Ne la négligez pas !

Le Material Design de Google se déploie

(Avril 2016)

Alors oui, nous allons parler de webdesign et de tendances, mais pas d’inquiétude, je ne listerai pas les 10 tendances webdesign en 2016.

Le webdesign se recentre sur l’expérience client

Le design web est en constante évolution. Chaque année qui passe amène son lot de surprises et de changements dans la façon dont nous interagissons avec les sites web, dont les standards sont toujours en mouvement.

Ces interactions entre l’utilisateur et les plateformes web (site, application mobile, etc.), ont poussé le webdesign à s’inscrire désormais dans une démarche d’expérience utilisateur.

La relation entre un site web et un utilisateur est sûrement des plus opaques, mais cela est en passe de changer. En effet, l’utilisateur expérimente une ergonomie, un fléchage à travers les différentes étapes de l’achat, lit des messages marketing, clique, change de page, de rubrique, se promène sur une carte ou cherche des informations.

Et Google lança le Material Design

L’année dernière, Google lançait un ensemble de règles de design nommé Material Design qui a pour objectif de créer un style contemporain se concentrant sur l’ergonomie de l’interface et la façon dont l’utilisateur naviguera sur celle-ci. Le Material Design dégage un aspect ultra-minimaliste se rapprochant beaucoup d’une autre tendance dont la popularité a explosé ces dernières années sur le web : le Flat Design.

Cependant, le Material Design utilise les ombres portées et la profondeur pour mieux afficher la relation entre les différents éléments graphiques.

En effet, le but recherché de ce design simplifié est de construire une vraie expérience pour l’utilisateur et de l’éclairer au cours de sa navigation en vue d’augmenter les interactions.

Retrouvez ci-dessous 3 éléments majeurs du Material Design :

Google propose avec le Material Design des couleurs inspirées par des teintes fortes et saturées juxtaposées sur des couleurs plus neutres, un contraste entre des ombres profondes et des reflets brillants. Le Material Design s’inspire de l’architecture contemporaine. Les palettes de couleurs sont inattendues et dynamiques.

Pour résumer, retrouvez la vidéo de Google sur le Material Design :

Où en sommes-nous avec le Material Design ?

Google travaille actuellement sur son navigateur Chrome, avec de nombreuses améliorations à venir. En effet, le navigateur sera doté d’une toute nouvelle interface mettant évidement en avant le Material Design.

Cette toute nouvelle interface sera normalement livrée avec la version 50 de Google Chrome.

Intéressant… n’est-ce-pas ? Mais le meilleur reste à venir car il est même possible de tester certaines nouveautés dès à présent. Enfin, en partie.

Comment activer les nouveautés sur son navigateur ?

- Installez la dernière version de Chrome

- Tapez “chrome://flags“ dans votre barre de recherche

- Dans la liste proposée, activez l’option “Téléchargements Material Design”

- Redémarrez votre navigateur, puis affichez votre page de téléchargement afin de voir des premiers

éléments très intéressants( voir ci-dessous).

Septembre 2016 : que se passe-t-il sur Google ?

La rentrée est très mouvementée pour qui s’intéresse au référencement naturel de son site internet. En effet, depuis fin août, et plus sensiblement depuis le 2 septembre, le moteur de recherche est en pleines turbulences, et de grands mouvements sont visibles.

Une mise à jour de filtre ou un mouvement plus profond ?

Les deux hypothèses font débat dans la communauté SEO : d’un côté ceux qui misent sur une mise à jour du filtre Penguin, de l’autre ceux qui pensent qu’il ne s’agit pas d’une mise à jour mais d’un mouvement de fond de l’algorithme.

A ce jour, aucune communication officielle de la part de Google, mais les spécialistes du SEO débattent et échangent sur leurs pratiques et expériences sur Twitter. Il semblerait que ce phénomène soit international car les référenceurs américains et britanniques échangent eux aussi sur le sujet.

Concrètement, quel est l’impact de cette mise à jour ?

L’effet, déjà amorcé depuis quelques mois, du local sur les requêtes géolocalisées, et l’importance du pack local pour un site se poursuit et se confirme. C’est-à-dire que les résultats des sites locaux ou géolocalisés sont privilégiés s’ils sont bien optimisés à ces fins.

D’autres misent sur l’impact des liens externes, très positifs pour la majorité des sites à condition que ces derniers aient assez de popularité.

Plusieurs SEO (dont une partie de ceux de Vu du Web) parlent d’une mise à jour du cœur de la machine et du fameux Phantom qui serait plus structurant et qui permettrait à Google de travailler l’amélioration de son algorithme au sens large.

Des mouvements plutôt entre le top 6 et le top 20

Depuis début septembre, sur certaines requêtes (nombreuses) les évolutions peuvent être de 50 à 60 positions en positif ou en négatif. Sur certains mots-clés, la première page de Google a presque été renouvelée. Mais en faisant plusieurs tests sur des requêtes dans plusieurs secteurs d’activité, on se rend surtout compte que les gros mouvements ont lieu entre la 6e et la 20e position pour le moment.

Les cas avec un renouvellement du top 3 nous semblent encore aujourd’hui assez rares.

Consécration du « droit à l’oubli » sur Google ; entre censure et protection de la vie privée.

(Mai 2014)

Le 13 Mai 2014, la CJUE (Cour de Justice de l’Union Européenne) a pris une décision historique qui risque d’être lourde de conséquences. Elle a consacré le droit à l’oubli numérique, déboutant ainsi Google de ses demandes. Ainsi, lorsque un moteur de recherche contient des informations sur une personne, cette dernière peut demander la suppression des liens la concernant de la liste des résultats.

Une décision qui va à l’encontre des principes du géant Américain

S’érigeant comme le porte-étendard de :

- la liberté d’expression,

- de la diffusion de l’information et

- de l’absence de censure,

cette décision attendue porte clairement atteinte aux « valeurs » de Google.

Elle implique désormais la possibilité de se façonner l’image numérique que l’on souhaite sans plus avoir à traîner des informations négatives. Elle fausse la réalité au bon vouloir de la personne concernée.

Mais cette décision paraît juste au fond, puisque le « droit à l’oubli » reconnu en droit, permet à toute personne ayant payé sa dette à la société de ne plus se voir montrée du doigt. Pourquoi laisser paraître des informations qui n’ont plus lieu d’être ? Tout se discute !

Une décision suffisante ?

Selon la CJUE, les moteurs de recherche sont responsables du contenu indexé. Il s’agira donc pour les ressortissants européens de faire disparaître de l’index des éléments contrariants pour leur e-réputation. Cependant, la décision ne dit rien quant au contenu originel indexé. Certes, il ne sera plus accessible via Google, mais il sera pourtant bien présent.

Cette décision est louable dans une certaine mesure mais elle n’empêchera pas les mauvais éléments de circuler.

Comme un goût de déjà-vu…

Cette décision n’est pas sans rappeler un précédent dans l’Etat de Californie. Dès 2015, les mineurs pourront exiger le retrait de leurs données personnelles de la toile. Sont uniquement concernées les données postées par eux mêmes.

Cette loi Californienne accorde ainsi un « RESET » aux mineurs, leur permettant de faire peau neuve pour l’avenir, où il est parfois difficile de faire une recherche d’emploi quand on traîne derrière soi des dizaines de casseroles.

Baidu sort son standard Mobile Friendly

(Janvier 2016)

A l’ère du mobile, Baidu, le plus grand moteur de recherche chinois, traite quelques milliards de requêtes sur mobile chaque jour. Face à la forte croissance des mobinautes en Chine, Baidu, à l’instar de Google, a établi ses propres standards mobile friendly avec un outil de test directement intégré dans Zhan Zhang, l’équivalent Baidu de l’outil Search Console de Google, pour vérifier que votre site respecte ces standards. L’objectif est d’inciter les webmasters à développer des sites mobiles tout en prenant soin de l’expérience utilisateur.

Lorsqu’un utilisateur clique sur un résultat de recherche sur Baidu depuis son portable, son expérience utilisateur provient non seulement de la pertinence du résultat de recherche, mais aussi du temps de chargement et de l’expérience de consultation. Baidu s’engage alors dans l’amélioration de l’expérience de navigation sur mobile. Découvrez ci-dessous les critères d’accessibilité mobile établis par Baidu.

Lisibilité de la page

Baidu ne passerait pas de temps sur une page non accessible. La lisibilité d’une page doit prendre en compte la vitesse de chargement, la structure de la page et l’expérience de la navigation.

La vitesse de chargement

Une recherche menée par Baidu montre qu’un utilisateur peut patienter 3 secondes pour charger une page. Au delà de 5 secondes, 78% des utilisateurs perdent patience et quittent la page. Ainsi, la vitesse est devenue un élément important pour le classement des résultats de recherche.

La structure de la page

Une bonne structure doit mettre en avant le contenu principal. La page doit pouvoir s’ajuster automatiquement selon la taille de l’écran et l’utilisateur doit pouvoir identifier clairement le contenu de la page sans zoomer ou défiler. Le contenu principal doit se situer au centre, alors que les autres contenus ne doivent pas gêner sa lisibilité. En effet Baidu pénalise la surabondance de pop-up.

Expérience de la navigation

La structure de la page est la base de l’expérience de navigation. Afin d’obtenir un meilleur rendu pour les utilisateurs, Baidu recommande d’utiliser un contraste évident entre le contenu du texte et la couleur du fond ainsi qu’une mise en page soignée avec des paragraphes structurés.

Une autre recherche effectuée par Baidu montre que :

- Lorsque le contenu principal est un bloc de texte, le meilleur rendu sera : une taille de texte de 14 pixels (pas plus petit que 10px), un interligne entre 0,42 et 0,6 (pas plus petit que 0,2).

- Lorsqu’il y a plusieurs images dans le contenu principal, il faut garantir la qualité des images mais aussi uniformiser leur largeur.

- Lorsqu’il y a plusieurs liens hypertextes, les tailles des ancres de lien doivent être en 14 pixels avec un interligne de 13px, alors qu’en 16px l’interligne est de 14px. L’étendue de la zone sur laquelle le lien est cliquable ne doit pas être plus petite que 40px.

- Les dimensions de la zone cliquable dans le contenu principal doivent être plus grandes que 40px.

- Une même manipulation ne doit être associée qu’à une seule fonction.

Voici quelques exemples de mauvaise expérience de navigation :

Accessibilité aux ressources

Le standard de l’accessibilité aux ressources dépend du type de la page :

- Page d’accueil ou l’index : liens clairs et cliquables, contenu net et pertinent.

- Page de contenu texte (article, page, forum, etc.) : contenu complet et clair avec une mise en page soignée.

- Pas de format Flash

- Audio/vidéo : source de qualité, peut être déclenché automatiquement (auto play). Baidu pénalise le renvoi vers le téléchargement de logiciels tiers (comme par exemple lorsque vous êtes sollicité pour installer un lecteur vidéo).

- Téléchargement d’applications : téléchargement direct et dernière version.

- Page de texte : le texte doit pouvoir être lu directement ; évitez les textes en image difficilement interprétables par le moteur de recherche

Accessibilité aux fonctionnalités

Selon les fonctionnalités de la page, voici quelques conseils de Baidu :

- Page de produit : infos complètes sur les produits et le tunnel de conversion doit être court

- Page des résultats de recherche : les résultats de recherche interne doivent correspondre aux requêtes des visiteurs

- Page de formulaire (inscription, connexion, soumission des infos, etc.) : elles doivent être fonctionnelles et efficaces

Un exemple de mauvaise accessibilité aux ressources : utilisation du format Flash.

Bonus

Une fois que votre site est bien lisible et doté d’une bonne expérience utilisateur, Baidu vous propose des bonus pour obtenir des points supplémentaires :

- Fil d’Ariane cliquable qui permet à l’utilisateur d’identifier sa position dans le site

- Pour les sites de services : proposer un appel direct, localisation sur une carte

- Page de recherche : proposer plusieurs moyens d’effectuer sa recherche : vocal, image, scan, etc.

- Page de lecture : mode nuit, etc.

Bien référencer sa boutique de e-commerce !

(Avril 2014)

Vous avez décidé de vous lancer dans l’aventure e-commerce pour profiter du boom des achats en ligne ?

Plus que tout autre propriétaire de site web, vous êtes donc conscient des enjeux du référencement naturel pour le trafic de votre site, et des ventes qui en découlent. Mais en quoi un site de e-commerce est-il différent à référencer d’un site « classique »? Vu du web vous explique les principaux leviers à prendre en considération pour votre boutique de e-commerce.

Choisir le bon nom de domaine

C’est la première étape, et qui ne doit pas être négligée. Il est important de miser sur la marque plutôt que sur le produit. En effet les noms de domaines utilisant des mots clés de type « chaussures-en-ligne.com » ne font plus recettes comme autrefois et peuvent même faire l’objet de pénalités par les moteurs de recherche voyant dans cette démarche une pratique abusive. Par ailleurs utiliser une expression générique comme nom de domaine c’est prendre le risque de se retrouver face à des concurrents dans un contexte différent (Wikipédia, YouTube…) et donc de ne pas réussir arriver premier sur le nom de son site !

Attention également de veiller à l’antériorité du domaine. Il serait dommage d’installer son site sur un nom de domaine qui a été sanctionné dans le passé par Google, suite à des pratiques douteuses des anciens propriétaires.

Travailler l’architecture du site

Contrairement à un site vitrine proposant une dizaine de pages à ses visiteurs, le site de e-commerce peut s’étendre sur des centaines, voire des milliers de pages.

C’est donc cette différence fondamentale qu’il faut prendre en compte. Pour se faire il est nécessaire de demander aux moteurs de ne pas indexer les contenus sans valeurs pour l’internaute afin qu’ils se concentrent sur les pages les plus importantes. En effet de nombreuses pages sont souvent générées automatiquement par le biais des recherches internes, ou des filtres de choix.

Par ailleurs, les moteurs de recherche appréciant une organisation claire et structurée des contenus, il est très important de passer par un travail préalable sur la structuration du site. A cet effet, il est vivement conseillé d’organiser ses catégories en fonction des expressions stratégiques de son secteur. Une structuration claire que l’on retrouvera par exemple au niveau des url.

Rédiger des descriptions uniques pour chaque produit

Une erreur commise par de nombreux webmaster de boutique e-commerce est de réutiliser les descriptifs fournis par les fabricants. S’il s’agit d’un gain de temps certain, vous risquez en revanche de proposer les mêmes contenus textuels aux moteurs que vos concurrents. Vous prenez également le risque de proposer des descriptifs quasiment identiques parmi vos références pour des produits pourtant différents. Google risquera d’interpréter cette duplication comme une absence de valeur ajoutée de vos contenus pour les internautes et de reléguer les pages de votre site loin dans ses résultats.

Il est donc important de passer du temps à rédiger des descriptifs uniques et de qualité pour chaque produit que l’on souhaite mettre en avant sur les moteurs de recherche. Si la tâche peut paraître fastidieuse, l’effort sera récompensé en termes de visibilité.

Ne pas négliger les images

Autre spécificité du e-commerce : l’importance des images qui accompagnent la description des produits et qui ont toutes leur utilité en SEO. De plus en plus les internautes utilisent Google Image dans leurs recherches de contenus, c’est pourquoi l’utilisation de titres pour chaque images est un élément à ne surtout pas négliger ! Il s’agit donc de décrire le visuel tout en restant dans le champ sémantique de la page, à l’aide d’une expression soigneusement choisie en fonction de son potentiel de recherche ! La balise « alt » ne doit pas être négligée car elle permet aux personnes déficientes visuelles (soit autant de clients potentiels) d’accéder aux contenus du site. Un facteur d’accessibilité qui est en plus apprécié par les moteurs de recherche.

Les raccourcisseurs d’URL

(janvier 2016)

Avant de commencer, il est essentiel de savoir qu’est-ce qu’un raccourcisseur d’URL.

En naviguant sur le web, vous êtes sûrement déjà tombé sur ce type de liens. En cliquant sur ce lien, vous êtes redirigé vers une autre adresse qui est beaucoup plus longue. Pour mon exemple, j’ai pris une page interne du site de Vu du Web : .

Comme son nom l’indique, le but premier d’un raccourcisseur, ou shortener, d’URL est de réduire au maximum une URL. C’est essentiellement pour la partager sur les réseaux sociaux qui limitent le nombre de caractères d’un message.

A quoi peut me servir un lien raccourci ?

En plus de raccourcir une URL, on peut détourner l’usage des raccourcisseurs d’URL de plusieurs façons :

Cela permet de créer un lien unique, dont on pourra suivre les statistiques séparément des autres liens pointant vers la même page ;

Permettre l’insertion de liens dans certains forums, pages HTML ou Wiki qui n’acceptent pas les liens comportant des caractères spéciaux ;

Masquer l’URL d’origine: une technique utilisée par les spammeurs et par les blogueurs qui souhaitent cacher des liens d’affiliation par exemple.

Quel raccourcisseur choisir ?

Il serait fastidieux de vous énumérer toute la liste des shorteners. Je me suis donc limité aux 2 raccourcisseurs d’URL que j’utilise le plus et qui répondent à la plupart de mes besoins.

Bit.ly

Je pense que Bitly est le shortener que j’utilise le plus. Bitly offre de nombreuses fonctionnalités pour organiser et contrôler facilement vos URL raccourcies. Afin d’utiliser toutes les fonctionnalités de Bitly vous devrez être inscrit sur le site mais croyez-moi, ça vaut le coup !

Une fois inscrit, on a la possibilité de personnaliser les URL, voir l’historique des liens que l’on a raccourcis, les rechercher, les regrouper et les classer. Il est aussi possible d’ajouter des petites notes afin de se rappeler ce qu’ils font et où est-ce que vous les avez publiés. En utilisant l’extension Chrome de Bitly, vous pourrez créer et partager facilement une URL raccourcie.

Bitly propose aux utilisateurs inscrits des fonctions de tracking. Ainsi vous serez en mesure de suivre le nombre de clics et le nombre de partages sur les réseaux sociaux de chacun de vos liens Bitly.

Goo.gl

Google a lancé son propre raccourcisseur d’URL en 2009, mais celui-ci n’était accessible qu’au travers de certains outils de Google comme Feedburner. Aujourd’hui, il est accessible partout et par tous ! Goo.gl a été créé avec 3 objectifs :

la stabilité : l’outil doit être toujours disponible

la sécurité : l’outil doit être protégé contre les malwares et le phishing

la vitesse : l’outil doit être rapide et générer des URL très courtes

Goo.gl permet bien évidemment de raccourcir une URL, mais pas que… Il permet aussi de voir pour chaque lien raccourci, le nombre de clics, les pays d’origine des internautes, leurs navigateurs, leur système d’exploitation ou les éventuelles erreurs rencontrées.

Oui vous pouvez piéger vos collègues avec les raccourcisseurs d’URL !